Im letzten Blogartikel habe ich die MEESTAR-Methode zur ethischen Evaluation von Technologien von Karsten Weber (2019) vorgestellt. In dem Aufsatz von Weber (S. 431-444) wird auch der Ethics Canvas von Reijers/Lewis u.a. des ADAPT Centre/Dublin als Tool erwähnt. Der Ethics Canvas basiert auf dem bekannten Business Model Canvas.

Der Ethics Canvas ermöglicht ein partizipatives und diskursives Brainstorming der ethischen Folgen von Technologien, die im Rahmen von Forschung und Innovation entstehen. Das nicht-kommerzielle Tool eignet sich speziell für Lehrende, Forschende, Unternehmen und politische Entscheidungsträger, – die Zivilgesellschaft wird hier nicht explizit aufgelistet. Man kann den Ethics Canvas ausdrucken und gemeinschaftlich ausfüllen oder online bearbeiten, speichern und teilen. Dafür haben die Entwickler des Canvas eine Webseite samt Handbuch erstellt.

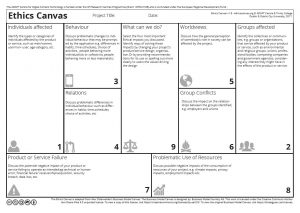

Die zentralen Fragen , die der Ethics Canvas stellt, lauten:

- Welche Personen und Gruppen sind von der Technologie bzw. dem Produkt oder Service betroffen?

- Von welchen möglichen ethischen Folgen sind diese Personen und Gruppen betroffen?

- Wie kann man diese ethischen Probleme lösen?

Berücksichtigt wird auch der problematische Ressourcenbedarf eines Produkts oder Dienstes (Energie, Daten usw.), als auch mögliche Produktfehler und -schwächen.

CC BY-SA 3.0 ADAPT Centre/Trinity College Dublin/DCU 2017

Die Autoren des Ethics Canvas gehen davon aus, dass man ihn in rund 1,5 Stunden gemeinschaftlich ausfüllen kann. Der inhaltliche Aufbau des Canvas beruht auf wissenschaftlichen Ansätzen aus der Technikforschung und Philosophie. Wichtig ist den Autoren, dass Technik nicht deterministisch gedacht wird, sondern Menschen mit der Technik interagieren und sich diese aneignen. Deshalb wird im Ethics Canvas so viel Wert auf Verhalten und Beziehungen gelegt.

Im Unterschied zu MEESTAR ist der Ethics Canvas ein allgemeineres Brainstorming- und Analyse-Tool, das sich nicht mit der konkreten Risikoabschätzung von Technologien befasst. Wie MEESTAR beruht der Ethics Canvas auf dem gemeinsamen Austausch der Stakeholder. Unterschiedliche Perspektiven und Interessen werden sichtbar. Aber auch hier gibt es – wie bei MEESTAR – keine Lösung für Wert- und Interessenkonflikte, – außer Kompromisse, die in der Diskussion gefunden werden müssen und bei denen sich Machtverhältnisse negativ auswirken können.

Was ich beim Ethics Canvas vermisse, ist die Raumkategorie bzw. die Frage, wie sich eine Technologie auf die Raumbildung und -gestaltung auswirkt, – ein ganz wichtiges Thema im Hinblick auf Sozialräume bzw. die Smart City-Diskussion.

Was MEESTAR und Ethics Canvas beide nicht bieten, sind Alternativen zu den behandelten Technologien. Man hat nur die Möglichkeit, sich mit einem bestimmten technischen Produkt zu befassen und keine Chance, über die Sinnhaftigkeit des gesamten Projekts und dessen Annahmen und Ziele zu sprechen. Dieses Denken in Alternativen wird dagegen von Szenario-Methoden gefördert. Hier können Teilnehmer*innen die Frage diskutieren, welche Zukunft und welche Technologien sie sich aus normativer Perspektive wünschen. Mehr zu Szenario-Methoden im nächsten Blog-Artikel.